导读:你是否曾经好奇,未来的机器是否能够像人类一样聪明,甚至“认知”这个世界?在这个科技日新月异的时代,答案或许比我们想象的更近一步。针对以上问题,肖仰华教授带来了一场精彩纷呈的演讲,为我们揭示了机器智能发展的最新动向与未来展望。

肖仰华教授从智能的本质出发,深入剖析了智能与知识之间的紧密联系。他认为,智能不仅仅是大脑的能力,更需要身体的参与,两者必须身心一体化,才有可能真正解决人工智能的终极难题。智能可以被视为知识的发现和应用,而知识则是人类对于世界被证实为真的信念。通过数据、信息和知识之间的区别与联系,肖教授为我们构建了一个清晰的知识认知框架。

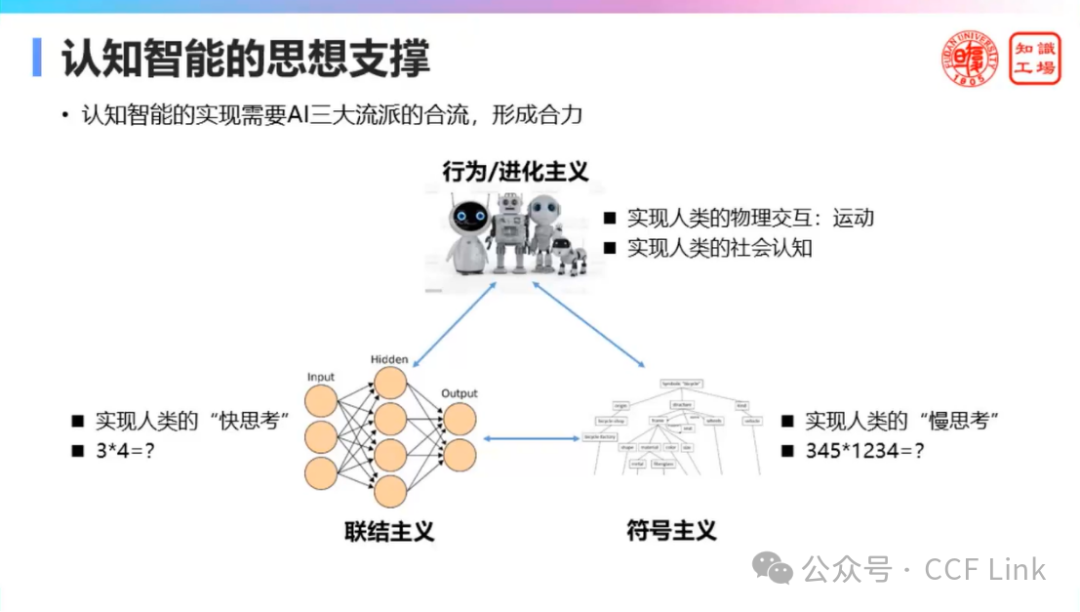

在演讲中,肖仰华教授还详细阐述了认知智能的实现路径。他指出,要实现认知智能,需要符号主义、联结主义和进化主义三大流派的合力。符号主义以知识图谱为代表,实现慢思考;联结主义则通过统计关联,实现快思考;而进化主义则强调通过反馈和试错来解决问题。他特别强调了具身学习的重要性,认为这是实现认知智能的重要途径。

图1:认知智能的思想支撑

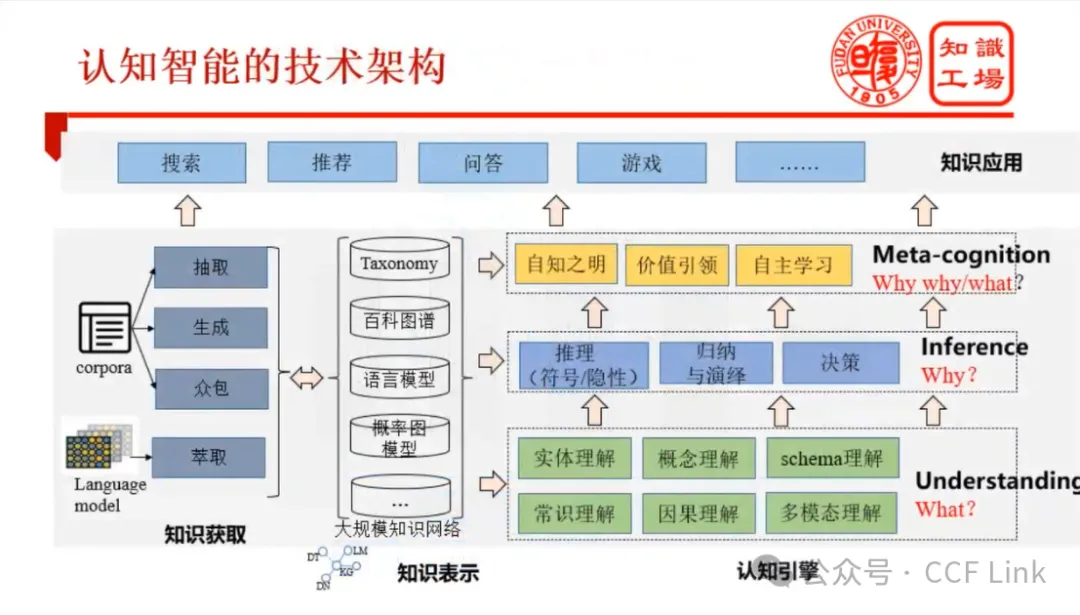

此外,关于知识获取、理解和应用的最新趋势,肖教授指出,大规模预训练语言模型的出现对知识库的构建产生了巨大冲击,而生成式预训练模型则为知识获取提供了新的手段。在知识理解和应用方面,他强调了多模态理解能力、因果推理能力和语言认知能力的重要性,并展示了这些能力在实际应用中的巨大潜力。

如果你想深入了解机器如何“认知”世界?肖教授的这场演讲绝对不容错过!

精彩片段

在知识获取方面,我们首先一定要重视就是大规模预训练语言模型,像GPT3这种大规模预训练语言出来之后,它对知识库的构建实际上是有很大的冲击作用的。很多时候,大规模训预练模型已经学到了非常多的有用的知识,但是它就好比是一个很博学的人,它看到很多很多东西,但是它说不出来。因此我们认为它只是一个知识的蓄水池,它还需要适当的诱导手段。所以大家看到的最近的Large prompting探测技术,还有Prompt提示技术,或者Instruction指示技术,来指示预训练模型怎么样去获得相应的知识和答案。

第二个就是在很多领域,单单Language Model是不足以表达的,单单Knowledge Graph也是不足以。实际上我们很多领域,包括传统的本体、框架、逻辑知识,这些东西都要混合使用,才有可能真正解决一个场景的问题。所以KG大规模知识网络演进趋势日益明显。

图2:认知智能的技术架构

知识获取的手段,我们除了传统的抽取和用人众包,最近的技术趋势是这两个象限:一个就是通过大规模预训练语言模型去萃取,而这种萃取可以设计探针、prompt模板,还有Instruction,来从预训练模型里面诱导出你要的知识。第二块就是用生成,有很多预训练模型是面向生成任务的,叫生成式预训练模型。我们把你要生成的那些知识给个框架,它就能帮我们生成很多知识,这两个趋势是很值得关注的。

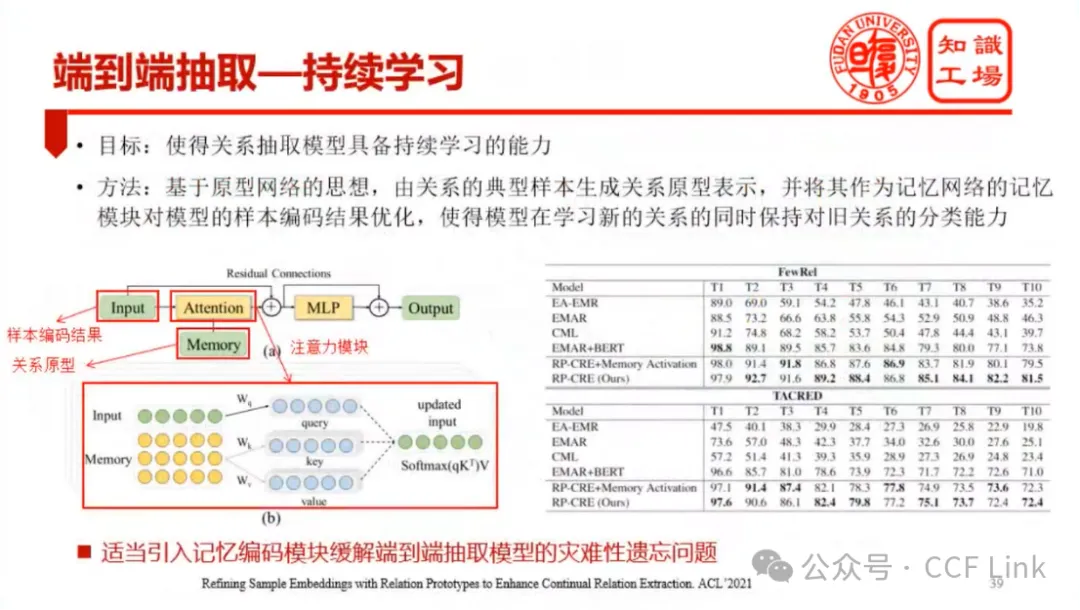

图3:端到端抽取—持续学习

还有一个很重要的趋势,复杂知识抽取是现在非常重要的一个形态,这个主要是面向,要想理解很多领域的文档,就需要复杂抽取,它不是简单的三元组关系,是多元关系。我们在这个方面,发展了叫知识诱导、知识指引下的基于模板的抽取。用模板的方法去抽取知识,往往会有语义漂移的问题,怎么解决呢?我们可以用一些先验知识来引导它,使得它把正确的pattern执行在正确的上下文来做知识获取。如果你从文本里面获取知识,现在很多都是端到端抽取,这时候基底模型很重要。还有就是抽取策略,大家现在获取知识的时候,很多都是构建知识图谱,是三元组,就是实体和关系。以前的做法一般都是先实体后关系。那么最近我们发现先关系后实体去抽,实际上也是一个很不错的策略。还有就是在深度端到端抽取里面大家经常会碰到“灾难性遗忘”这个问题,就是在新的语料上去确认之后,它把以前东西的模式给忘了,这时候需要引入一些Memory机制来解决这个问题……